在 AI 绘画领域,我们一直在追求更快的出图速度和更低的硬件门槛。Z-image-turbo(简称“造相”)是是阿里巴巴通义实验室于 2025 年底基于 Stable Diffusion WebUI 开发、发布的高效图像生成模型,60 亿参数、8 步采样等是其核心特性。它集成了多项加速技术,如 LCM (Latent Consistency Models) 和高效的模型与采样器,旨在实现秒级出图的极速体验。然而,高性能 AI 绘图往往需要强大的本地 GPU 支持。对于许多没有专业显卡的用户来说,这成为了一道门槛。本文将详细指导您如何利用 Google Colaboratory (Colab) 提供的免费或付费云端 GPU 资源,轻松部署 Z-image-turbo,彻底释放其速度潜力。

Z-image-turbo

-

Z-Image-Turbo:专注于快速推理,能够在低资源设备上高效运行,适合实时应用,支持中英文双语文本渲染(中文表现优异)。

-

Z-Image-Base:基础模型,适合开发者进行微调和二次开发。

-

Z-Image-Edit:专为图像编辑任务优化,支持根据自然语言指令进行精确编辑。

Z-image 系列已经设限,但本文示例使用的为社区 4bit 量化版本,支持 NSFW。

准备工作

在开始部署之前,请确保您拥有以下几项准备:

- Google 账号: 用于登录 Google Colab 并挂载/使用 Google Drive。

- 网络环境: 稳定的网络连接,以便顺利下载模型和运行环境。

- Hugging Face 账号 (可选但推荐): 如果您需要下载大型模型,拥有一个账号并设置好访问令牌会更方便。

部署过程

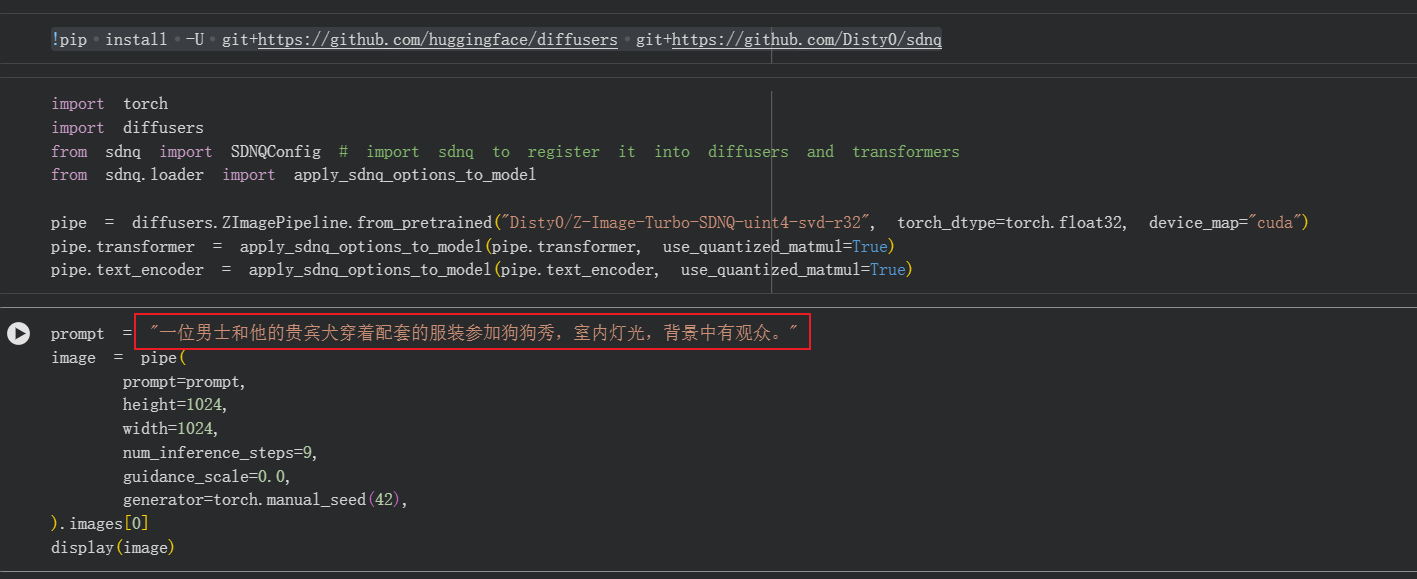

首先,我们点击 打开基于 4bit 量化版本 Z-image-turbo 的 jupyter 笔记本文件。

!pip install -U git+https://github.com/huggingface/diffusers git+https://github.com/Disty0/sdnq

import torch

import diffusers

from sdnq import SDNQConfig # import sdnq to register it into diffusers and transformers

from sdnq.loader import apply_sdnq_options_to_model

pipe = diffusers.ZImagePipeline.from_pretrained("Disty0/Z-Image-Turbo-SDNQ-uint4-svd-r32", torch_dtype=torch.float32, device_map="cuda")

pipe.transformer = apply_sdnq_options_to_model(pipe.transformer, use_quantized_matmul=True)

pipe.text_encoder = apply_sdnq_options_to_model(pipe.text_encoder, use_quantized_matmul=True)

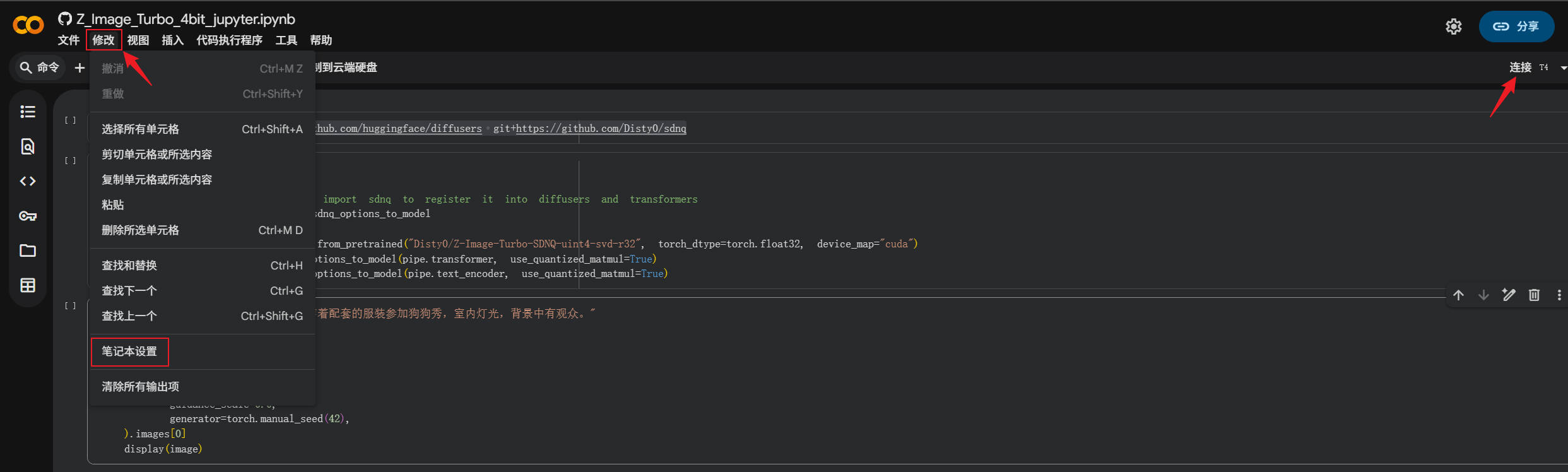

我们在 Google Colab 中,需要为 Z-image 项目分配合适的 GPU 加速资源,这是至关重要的一步:

- 点击打开顶部菜单栏的『修改』菜单, 选择『笔记本设置』。

- 在『笔记本设置』中选择 “T4 GPU” (对于免费用户,这是最佳选择) 或更高的配置(例如 A100,如果订阅了 Pro+)。

- 运行时类型选择 Python 3,点击『保存』。

运行时的修订也可以右上角的『连接』,在下拉菜单中选择『更改运行时类型』。

然后,在确定好提示词之后,就可以点击上方的『全部运行』开始执行顺序执行两个单元格的代码了。

运行与效率

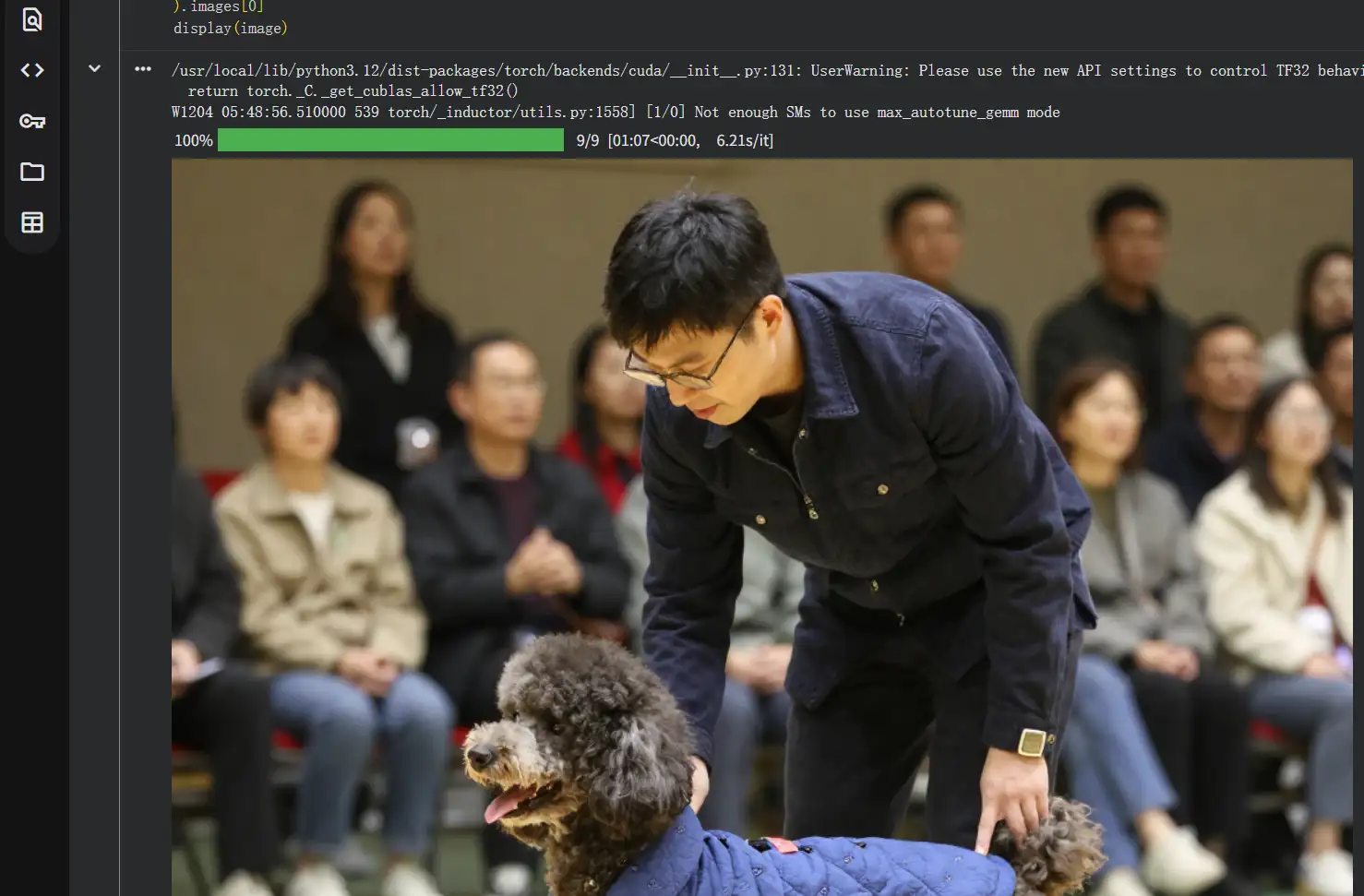

示例不做修改,直接开始运行。需要先安装 z-image-turbo 及必要的依赖。

完成项目部署和依赖安装后,加载 Z-image-turbo,开始进行推理。

因为我们部署的是 4bit 量化版本,效率很高,1 分钟(实际推理耗时 01:07) 1 张图。至于和完全版本的质量差异,作者是无法识别并且不在意的。

结语

本文示例仅仅将量化本的 Z-image-turbo 部署在云端(Google colab),有效解决了本地硬件不足的问题。但是,很显然,我们不可能每次生成图片都需要将整个部署流程都完整跑一边,因此,如果能将 webui 部署到 google colab,通过远程访问公网 url,输入我们的图片生成指令,实时生成、显示、下载才是生产解决方案。我们后续将和大家分享如何将完整的包含 webui.py 的 Z-image-turbo 部署到 google colab,并借助 ngrok 或 cloudflare tunnel 进行内网穿透以提供公网访问的方法。

更多精彩,敬请关注「老 E 的博客」!

文章评论

感谢大佬喂饭教程