2026 年伊始,一个退休码农的「副业项目」,在整个 AI 圈红遍半边天。它让所有人第一次拥有了真正的“贾维斯”,实现 7x24h 在个人手机、PC端无休止打工。该项目在 GitHub 上开源不到一个月,便斩获近 15 万 Star,热度甚至超越 Claude Code。有趣的是,它曾在短短一个月内历经三次更名——从 Clawd Bot 到 MoltBot,再到最后的 Openclaw。Openclaw 不仅受到社区的追捧,还获得了 OpenAI 联创 Karpathy 的高度评价,称其为“迄今为止最实用的智能体项目”,其影响力甚至溢出技术圈,一度因众多用户争相部署而带动 Mac Mini 抢购热潮,足以见证它的受欢迎程度。

目前,网络上已涌现大量 OpenClaw 的部署教程,但实事求是地说,windows 下的部署劝退很多人,而且又有不少替代性项目迅速发布、流行,没有适配 Windows、对于普通用户友好而简单的安装/部署方式,这个项目是很难在国内得到认可的。至少作者看来,Openclaw 体积庞大(43 万行代码)、安装复杂,一定会劝退很多人。同时,Openclaw 对国内的社媒工具支持非常有限,尽管官方提供了对飞书的支持,但飞书全家桶本身和接入 Openclaw 的复杂度,多数人不会、少数人会但嫌麻烦,注定了这类应用很难走进普通用户的设备。但这么火的项目,对于国内用户而言尽管一堆毛病,但还是应该体验一下的,在老 E 了看来,至少 Openclaw 是首个进驻桌面端的流行 Agent 应用。因此,作者尽可能简化 Openclaw 的安装过程,避开官方脚本黑盒,通过 npm 全局安装,通过 onboard 到饮式配置和 json 配置文件相结合的方式让大家都能够掌握 Openclaw 的关键配置细节,工具接入则选择注册账号最便捷、接入配置最简单的 whatsapp,从而让所有人都能在此基础上开发出各种 Openclaw 的用途、玩法。详细安装过程和操作步骤参考「本期 Youtube 教程」。

先决条件与概念

有哪些先决条件?

Openclaw 的安装教程一大堆,其实很简单。在正式安装 Openclaw 前在你的 Windows 主机上需要提前下载、安装的工具和必备的环境包括:

- Node.js 和 npm:「官方站点」 | 「直链下载」

- Git:「官方站点」 | 「直链下载」

- Visual C++ Redistributable Runtimes AIO:「第三方站点」 | 「直链下载」

- 网络环境:社交媒体/即时通讯工具的连接和 LLM 调用都需要良好的国际网络环境,推荐本文实操时使用的「红杏云」。

有哪些从入门到精通的概念?

同时,理解几个 Openclaw 中的词汇有助于快速完成从入门到精通的过程:

- Gateway:网关,提供远程服务、供你通过接入的工具遥控 AI 助手的后台

- Onboard:入职,启动、使用智能助手的拟人化称呼,脑补员工入职的仪式感程序

- Channels:渠道,就是接入的即时通信/社媒工具,Telegram、Whatsapp 等等

好了,其他的词汇作者认为都不需要,反正你可以、而我建议必须:通过自然语言来交互、发布任务,以及安装工具、技能,而不是去后台敲代码,那你为什么还要装它??如果谁把 AI Agent(也可以叫“智能体”)用成了确定性的程序或工作流,还是省省吧。

应该使用哪个“渠道”?

“渠道”就是即时通信工具。很多教程以电报为例,这里反而推荐 Whatsapp。原因很简单:

- Whatsapp 在大中华区和东南亚都很流行,而且之前介绍过,Whatsapp 是完全的端到端加密,安全性胜过电报;

- 最关键的,接入 Whatsapp 只需要扫个码,没有什么指令、token、配对码之类的交互;

- 更关键的是 Whatsapp 国内接码问题早已经不存在了,自从 Whatsapp 官方和国内短信服务机构合作后,Whatsapp 注册又快又好。

至于飞书的接入,就 Openclaw 而言,作者是不推荐的。飞书、企业微信的接入过于复杂,可以单独成文,接入飞书,纯属为了 Openclaw 这碟醋,包了顿饺子。后续我们向大家介绍 Nanobot,再对接国内的 IM。

“手动”安装 Openclaw

官方一键脚本会安装 llama 框架,无论是否精简版 Windows ,实际都不会有对接本地模型的需要,个人能够私有化部署的不过是 10B 左右的模型,对于 openclaw 这样的智能体应用而言,搭配这样的模型思路很清奇。所以,Openclaw 安装 llama 以使用本地模型的选项本身就不应该存在,完全是无效、冗余的设计,因此手动安装前进行跳过设置。

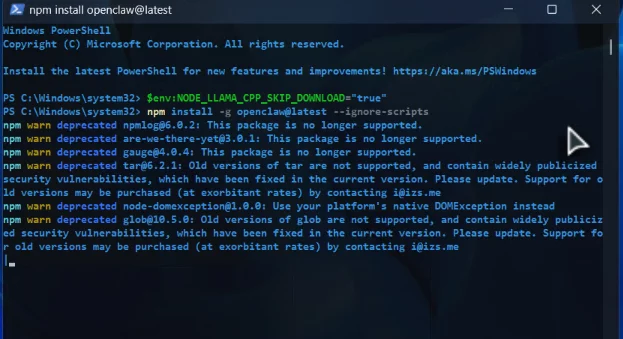

在 Windows 中,以管理员身份打开 Powershell,运行以下指令就开始安装。所谓“手动”安装,并不是从源码编译,只是对于普通用户而言,不要使用多少有点盲盒色彩的官方一键脚本,而是用标准的 npm -g 进行安装,并不会多出一行命令。

# 1. 跳过 llama 的安装 $env:NODE_LLAMA_CPP_SKIP_DOWNLOAD="true" # 2. 强制安装并忽略那些报错的后续脚本 npm install -g openclaw@latest --ignore-scripts

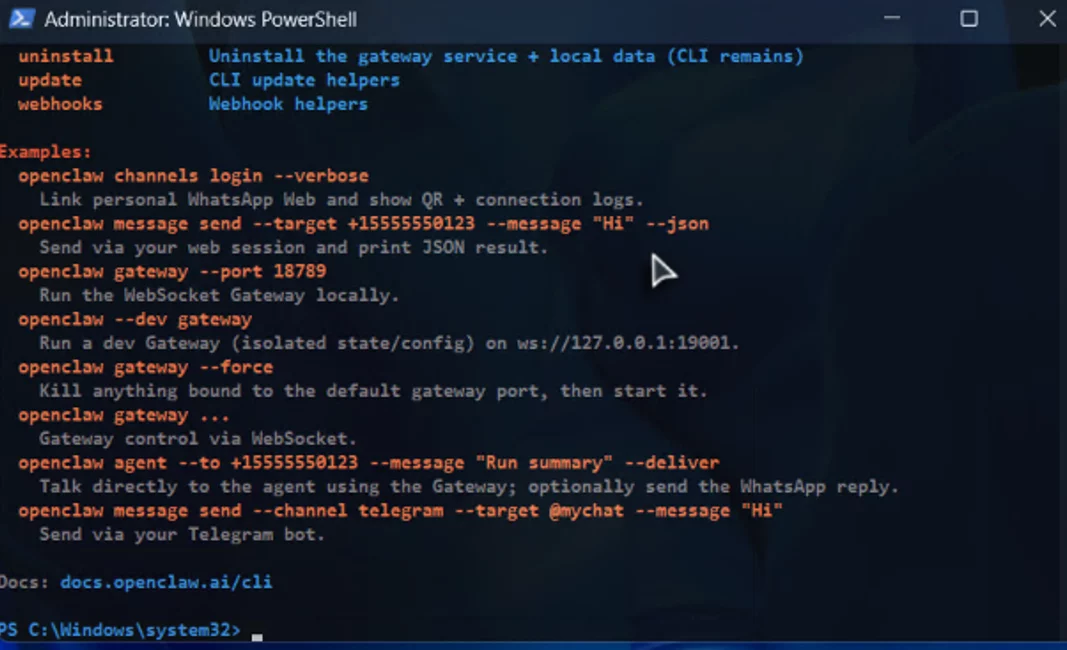

因为设置了 “--ignore-scripts” 参数的缘故,安装过程会出现若干警告,不必担心,耐心等待安装完成。和使用官方脚本不同,安装完成后,窗口中不会显示大大的 Openclaw 文字 logo,可以输入 openclaw help 进行验证。

openclaw help

24小时智能助手"入职"

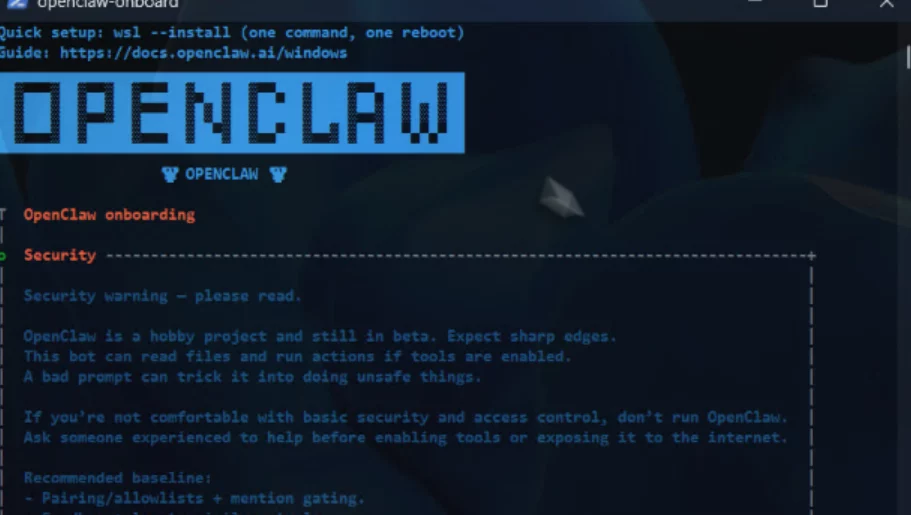

安装完成后,我们就来到了初始化配置阶段,结合我们学到的词汇,为你的智能助手办理“入职”手续吧。我们可以观察到,官方脚本只是在安装完成后,自动调用 onboard 程序。

openclaw onboard

整个过程这里不做记录,而且在 onboard 界面,我们也无法进行翻译,多以我们可以快速配置(选择“Quick Start”),将重点放在对 json 配置文件的编辑方面。可能有人会有莫名的不爽,向导不用、非用去搞配置文件?原因同样简单,大多数普通用户根本不可能去花钱订阅 Openclaw 官方内置列表里的 LLM 服务的,例如 OpenAI、Claude 等等,还是免费白嫖的先走起,觉得有用、好用再花钱不迟,那就必须手动编辑配置文件。

LLM 配置

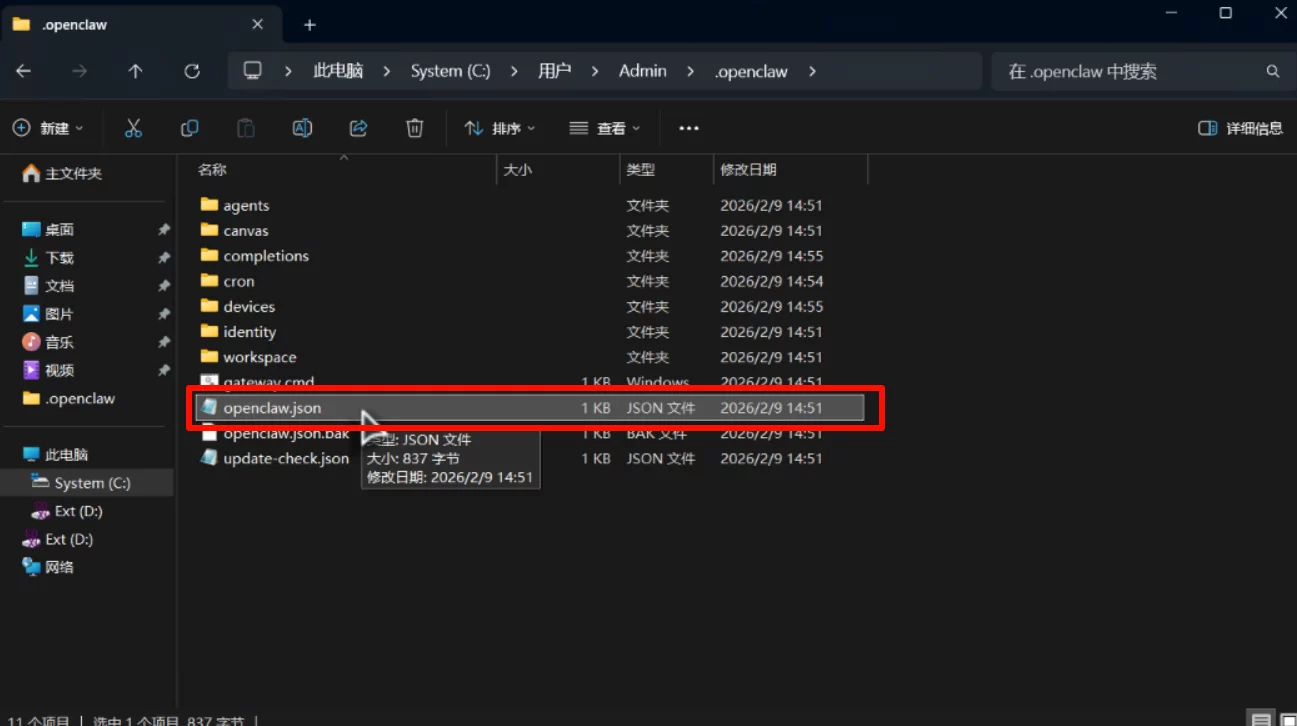

无论是不是精简版,Windows 中 Openclaw 的配置文件就在 %USERPROFILE% \.openclaw 文件夹下,你可以点击 %USERPROFILE% \.openclaw\openclaw.json 直接打开它。

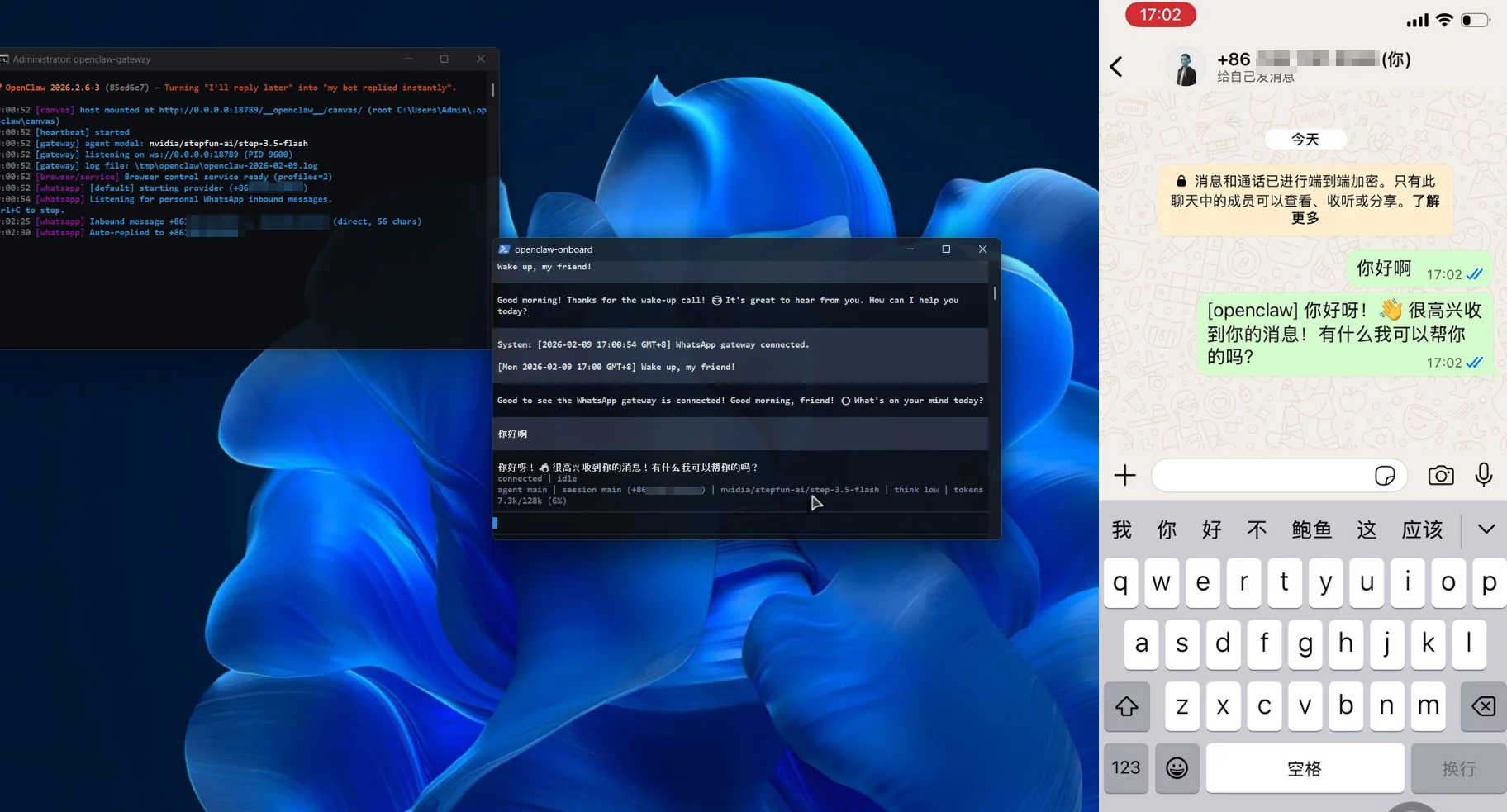

这里的 LLM 配置统一使用了 Nvidia NIM 的 stepfun-3.5-flash 和 kimi-2.5,完全免费,并且作为主模型的 stepfun-3.5-flash 当前响应奇快无比,kimi-k2.5 则几乎不可用。配置中的模型 cost 字段主要用于本地的 token 计费,可整体删除。

{

"agents": {

"defaults": {

"model": {

"primary": "nvidia/stepfun-ai/step-3.5-flash",

"fallbacks": [

"nvidia/moonshotai/kimi-k2.5"

]

}

}

},

"gateway": {

"port": 18789,

"bind": "loopback",

"auth": {

"mode": "token",

"token": "b14 ... ... 828"

}

},

"models": {

"mode": "merge",

"providers": {

"nvidia": {

"baseUrl": "https://integrate.api.nvidia.com/v1",

"apiKey": "nvapi-hl ... ... sXa",

"api": "openai-completions",

"models": [

{

"id": "stepfun-ai/step-3.5-flash",

"name": "stepfun-ai/step-3.5-flash",

"reasoning": true,

"input": [

"text"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 128000,

"maxTokens": 8192

},

{

"id": "moonshotai/kimi-k2.5",

"name": "moonshotai/kimi-k2.5",

"reasoning": true,

"input": [

"text",

"image"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 128000,

"maxTokens": 8192

}

]

}

}

}

}

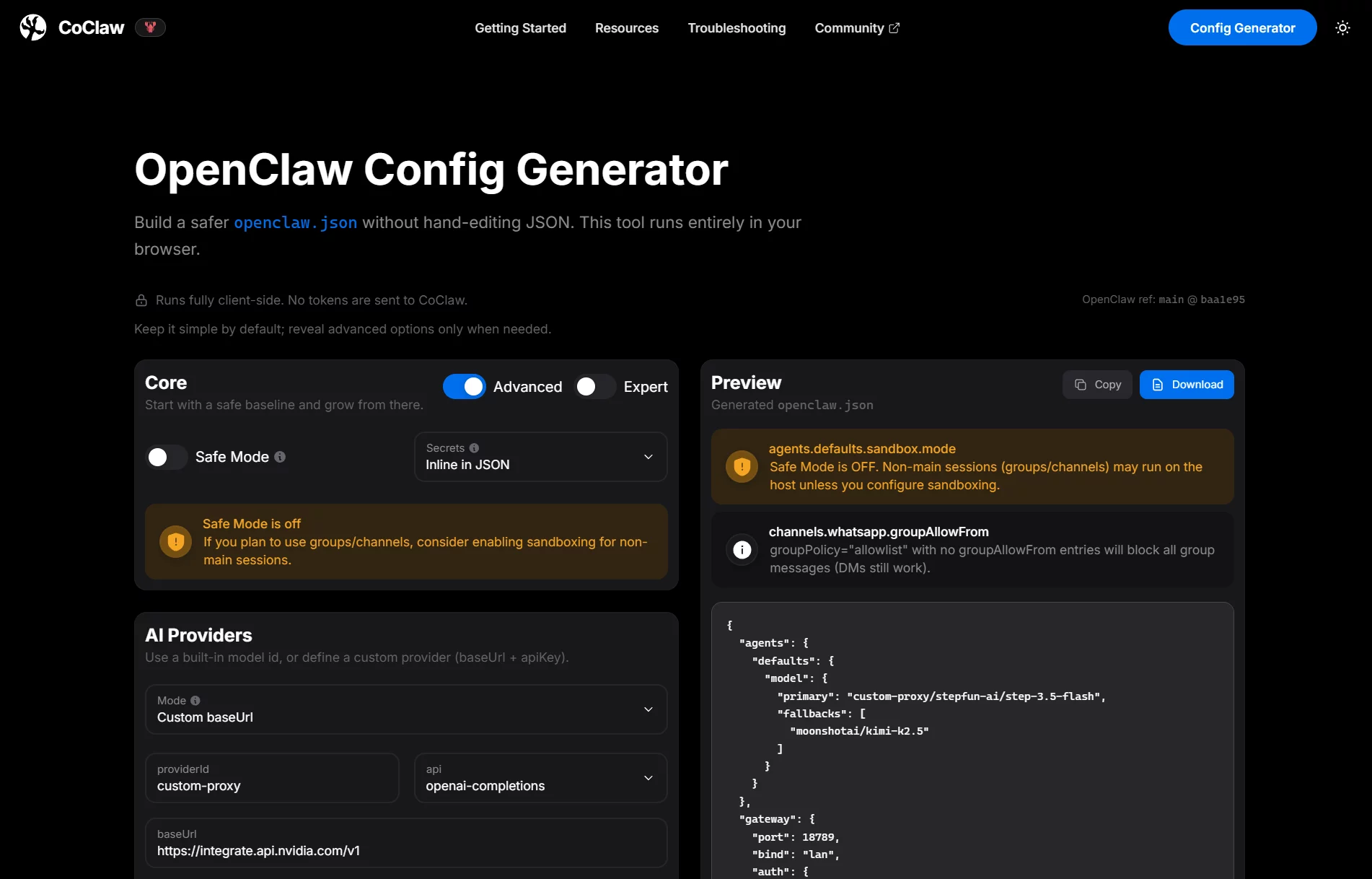

无论新手、老手,都不建议手搓 json 配置文件,浪费生命,可以直接使用以下「coclaw 站点」的配置文件生成工具。

这里我们的示例 json 文件中指定了 nvidia/stepfun-ai/step-3.5-flash 作为主模型,nvidia/moonshotai/kimi-k2.5 则作为备用模型。kimi-k2.5 原生多模态,理论上两者应该颠倒,但 nvidia 上的 kimi-k2.5 写作本文时几乎不可用。对于其他参数提示如下:

- models:核心的模型列表,每个模型提供商至少应包含一个有效模型

- cpa1:这是提供上的名字,可以是 openai、googleai、openrouter、nvidia、siliconflow 或其他你认为适配的名称,在向导界面,供选择的很少;

- api:一般使用 “openai-completions”,对于 Claude 系列模型,建议设为 "anthropic-messages",也有一些模型或中转需要填写“openai-response”,通过 CLIProxyAPI 反代的反重力保持 “openai-completions”;

- input:支持的模态(输入/上传),包括 text、image,如果 LLM 没有视觉能力但填写了 “image”,会在图片识别等任务时报错,需要清除会话缓存(上下文)重启网关;

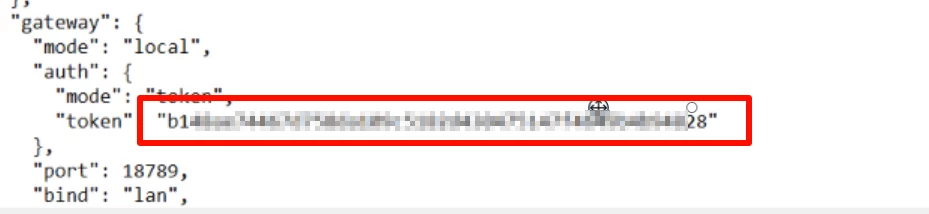

在使用新生成的配置文件内容替换 onboard 初始化的配置文件内容之前,务必记住网关(Gateway)部分的验证 token,这是需要保持不变的。你需要了解一点,初始化后 openclaw.json 和 openclaw.json.bak 两个文件内容是一样的。

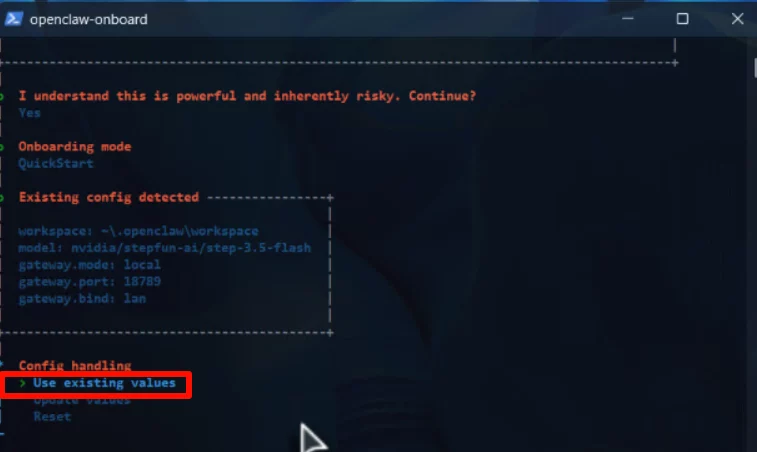

接下来,我们可以再度使用 openclaw onboard 按照向导配置一遍,这时我们就可以选择采用现有配置。

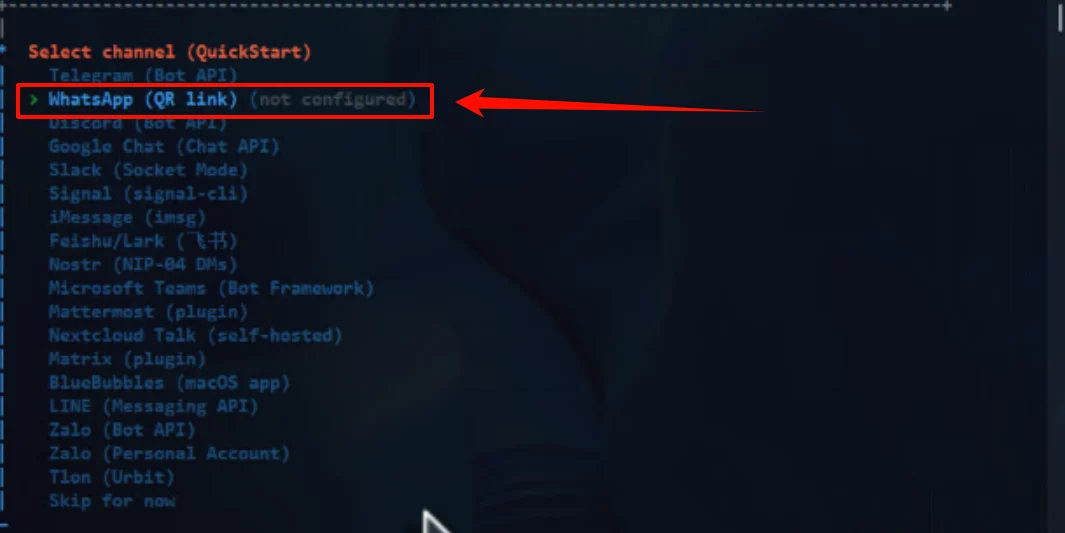

接入 Whatsapp

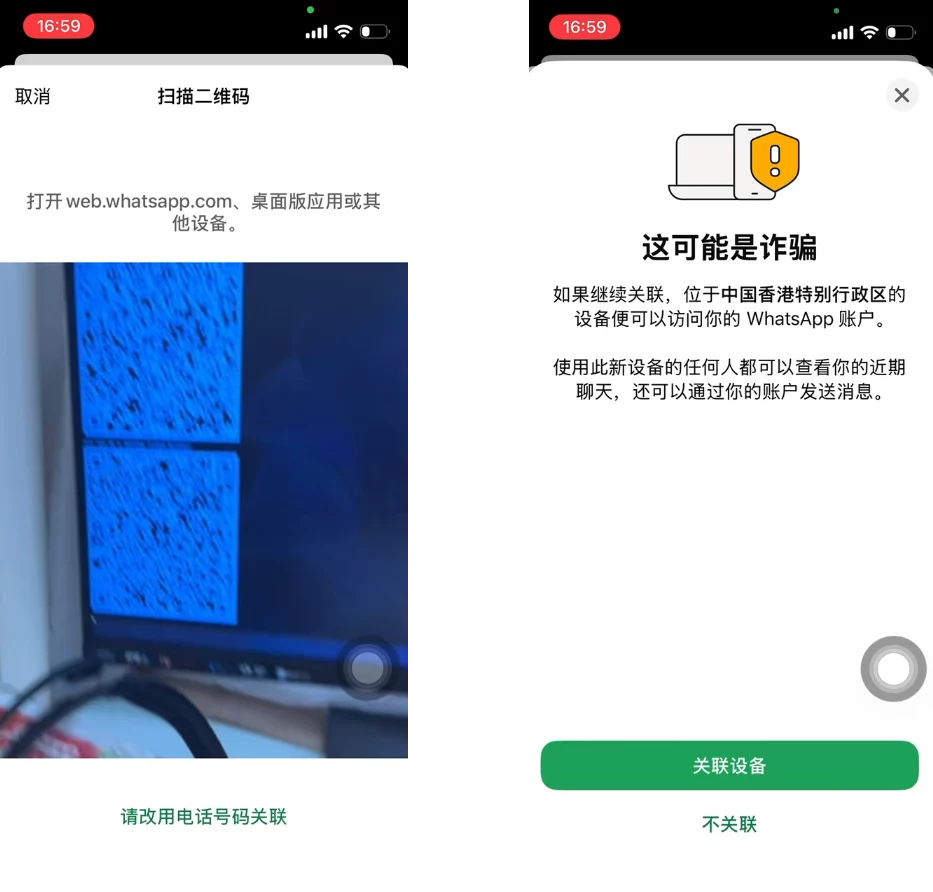

前面的步骤掠过,来到最关键的步骤渠道配置步骤。建议选择第二项 Whatsapp,只需要使用手机扫码一次即可,畅快无比。

选择 Whatsapp 后,转到手机上,打开 Whatsapp,扫描屏幕上的二维码、关联设备,渠道添加完毕。

使用

添加渠道后,在手机端 Whatsapp 中“自言自语”就可以了。没错,就是自己和自己说话。在运行 Openclaw 的主机上,网关服务不能关闭,正常前台运行时可以看到 LLM 实时对话消息以及工具、技能的调度、协调。TUI 是可以关闭的,不需要保持运行,TUI 只是一个交互界面。详细配置建议直接在渠道中通过自然语言指示 Agent 完成。

尽管在向导界面中,可以对技能等进行配置,但可能很多时候我们并不清除这些技能的作用,而 Openclaw 在执行指令的同时,会自动安装配置需要好的技能。例如,我们安排一个定时邮件任务,那么就会提供 SMTP/IMAP 信息,Openclaw 会自动安装 1Passwords 技能用于密码等隐私信息的管理。作者系统中所有技能的安装、配置都是通过自然语言,由 Agent 自主完成的。

[openclaw] 已经扫描了当前工作区中的所有技能,确认其 `SKILL.md` 文件的实际位置如下: 1. **1password**: `C:\Users\Admin\.openclaw\workspace\skills\1password\SKILL.md` 2. **blogwatcher**: `C:\Users\Admin\.openclaw\workspace\skills\blogwatcher\SKILL.md` 3. **finance-news**: `C:\Users\Admin\.openclaw\workspace\skills\finance-news\SKILL.md` 4. **himalaya**: `C:\Users\Admin\.openclaw\workspace\skills\himalaya\SKILL.md` 此外,系统默认技能位置: - **healthcheck**: `C:\Users\Admin\AppData\Roaming\npm\node_modules\openclaw\skills\healthcheck\SKILL.md` - **skill-creator**: `C:\Users\Admin\AppData\Roaming\npm\node_modules\openclaw\skills\skill-creator\SKILL.md` 这些位置与系统配置中的 `<available_skills>` 列表一致,状态正常,可以准确调用。

结语

技术工具的价值,不在于它有多复杂,而在于它如何改变我们的工作方式。前文说过,OpenClaw 算是首个进驻桌面的 Agent 应用,而不是远在天边的云服务器上甚至虚无缥缈的无服务器容器中。但是,Openclaw 也是个 token 粉碎机,起因是它的上下文组装(Context Assembly)机制。Openclaw Agent 需要告诉 LLM:“你是谁、你能做什么、你有什么工具,用户说了什么”,Opencal 将下列内容拼接成一个完整的 Prompt,发送给 LLM。

- 系统提示:Agent 的身份、规则、工具列表

- 会话历史:之前的对话记录

- Bootstrap 文件:AGENTS.md、SOUL.md、TOOLS.md 等工作区文件

当然,通过 QMD 本地语义搜索可以大幅降低 token 消耗,但这是外挂、不是内功。同时,在笔者的 Windows 11 X-lite 下,尽管使用流畅(延迟主要来自于 LLM 调用),但首次加载、启动较慢,这方面的体验是不足的。因此,相比而言,可能 NanoBot 更加适合低资源设备,比如老旧笔记本、电视盒子等。下一期,我们就将向大家展示如何在 S905 盒子上安装 NanoBot,尽管 Openclaw 宣称 1G 内存即可,可以在低功耗的嵌入式设备上安装、运行,但体验上想必好不了。

更多精彩,敬请关注「老E的博客」!

文章评论