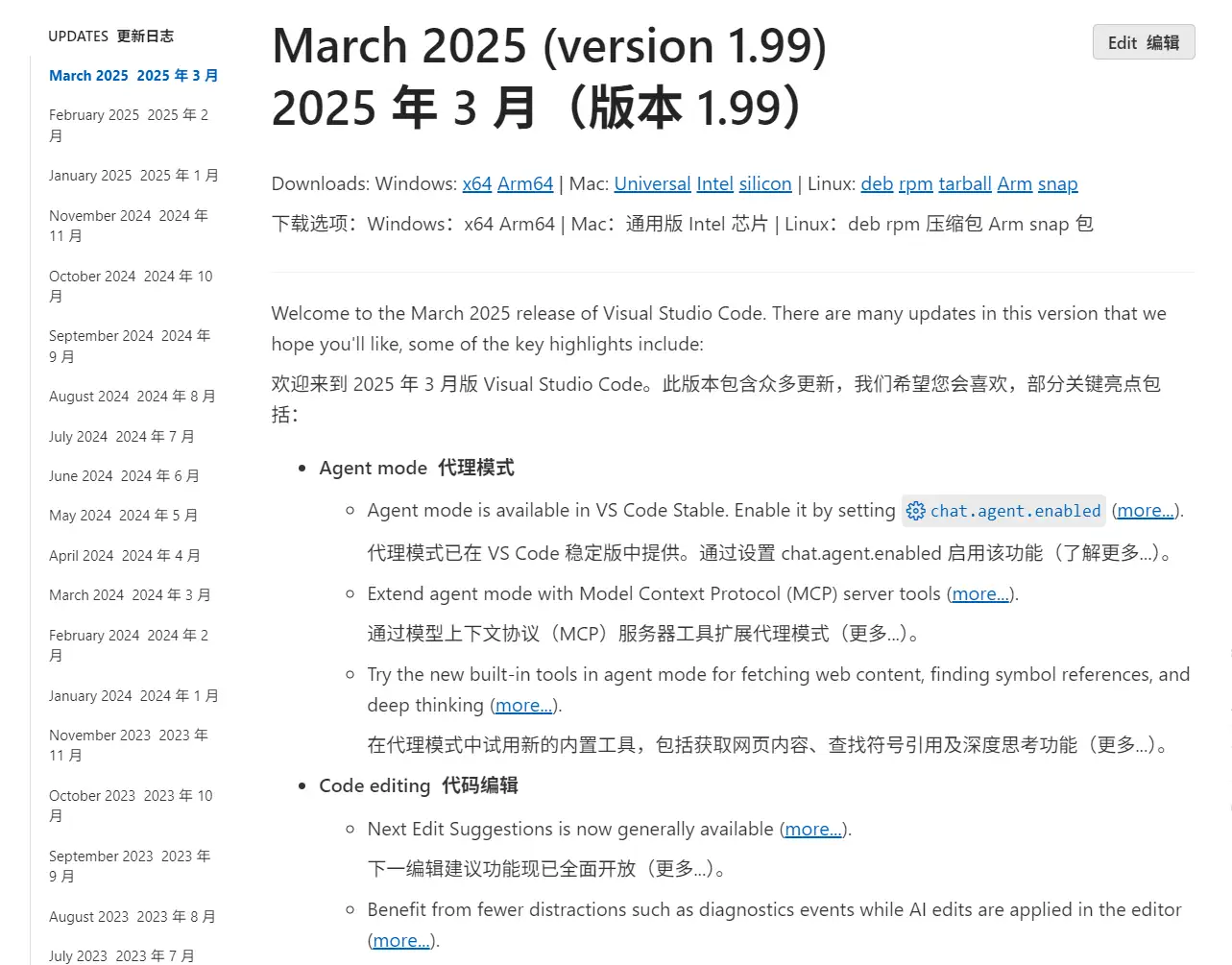

VScode 悄然升级至 1.99,继续丰富、强化 AI 能力。导入使用入第三方模型更简单、Agent 模式正式“发布”、支持接入 MCP 等功能都内置其中,相比 1.9.8-2 版本的体验式、编辑与聊天分离等 UI 设计都很大的进步,按照这个方向继续更新迭代,Github Copilot 100刀的年度订阅才是“真香”。原先需要通过第三方插件实现的功能,新版本都“原生”支持了,不知道 Cline/Roo code 等类似插件未来会何去何从,至于反向添加 Github Copilot 中 Claude 3.5 sonnet API 接入至第三方插件的“小妙招”本身就多余。

Agent 模式激活

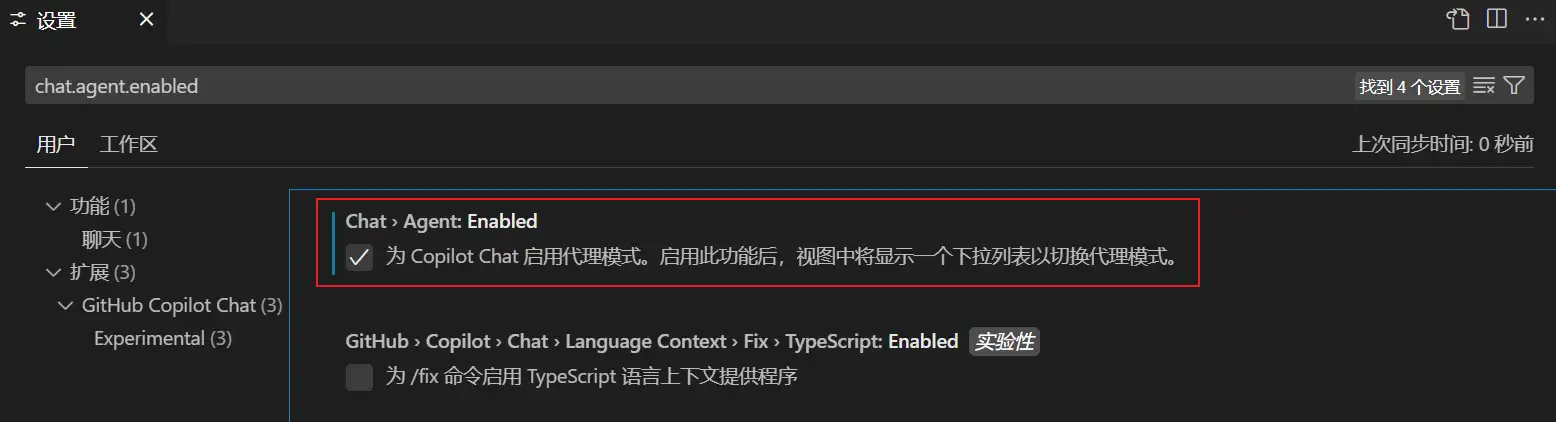

Agent 模式默认没有开启,需要激活「 vscode://settings/chat.agent.enabled」,已安装 VSCode 直接点击后勾选『为 Copilot Chat 启用代理模式』。

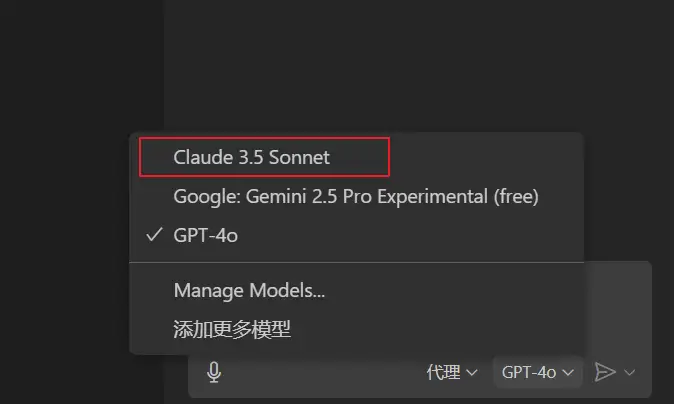

激活并选择 Agent 模式后,可用模型会有所变化,应该是取决于是否完整支持 Function Calling,例如这里的 deepseek-v3-0324 在 Agent 模式下就不再可选,同样的非 CoT 模型 GPT4o 保持可用。

额外模型添加

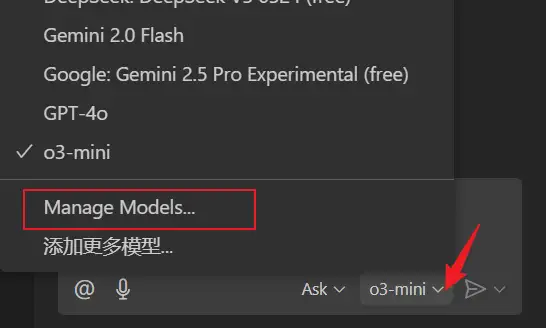

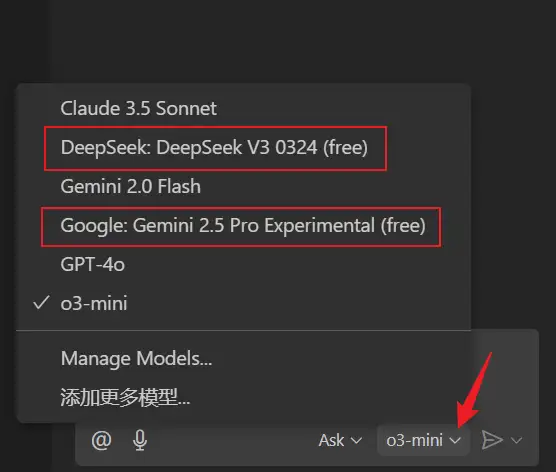

在 VSCode 1.99 中,打开内置的模型选择列表,点击『Manage Models...』就可以添加其他模型了。

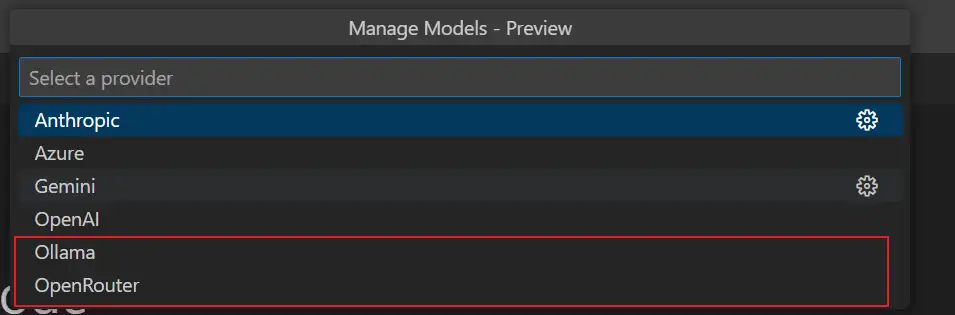

添加模型的第一步是选择模型提供商,内置的服务商列表还比较少,不过,在线的 OpenRouter 和本地的 Ollama 列表项也基本够用了。本文示例选择了 OpenRouter,ds-0324 和 gemini-2.5-pro 都是可以免费接入的,如果要接入本地或局域网内的 LLM,就选择 Ollama。

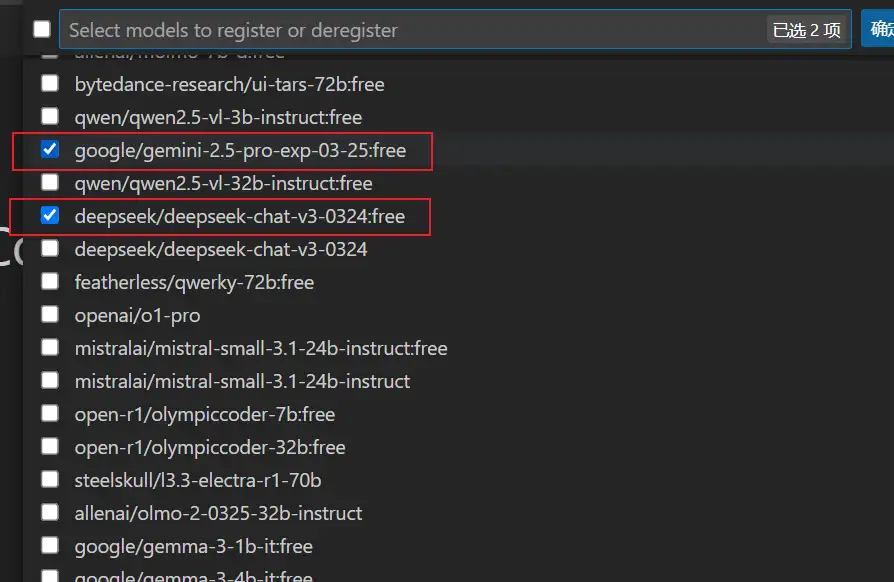

选择服务提供商后,直接粘贴 API Key 后,勾选模型提供商提供接入的模型,就完成了模型添加。

添加完成后,在询问/Ask 或编辑/Edit 模式下就可以选择包括新添加模型的所有模型了。虽然 OpenRouter 只是接入平台,可以直接接入如 chutes、gemini(google AI Studio),不需要多中转一次,但胜在 All in one,管理简单。

Github Copilot 的内置模型支持比较保守,一直没有接入 Claude 3.7 sonnet,相比 Cursor、Trae 等落后了,但如果你是白嫖用户,一定会注意到 Github Copilot 的 LLM 调用更为稳定,极少出现排队等待现象。

MCP 接入

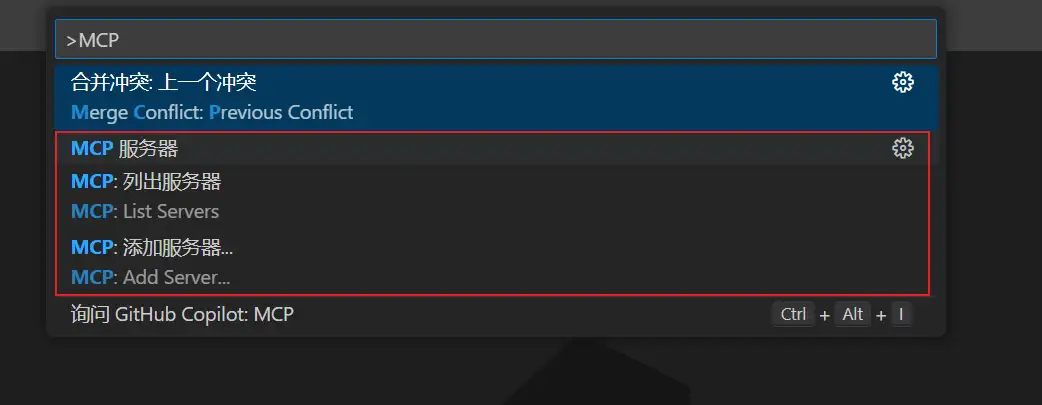

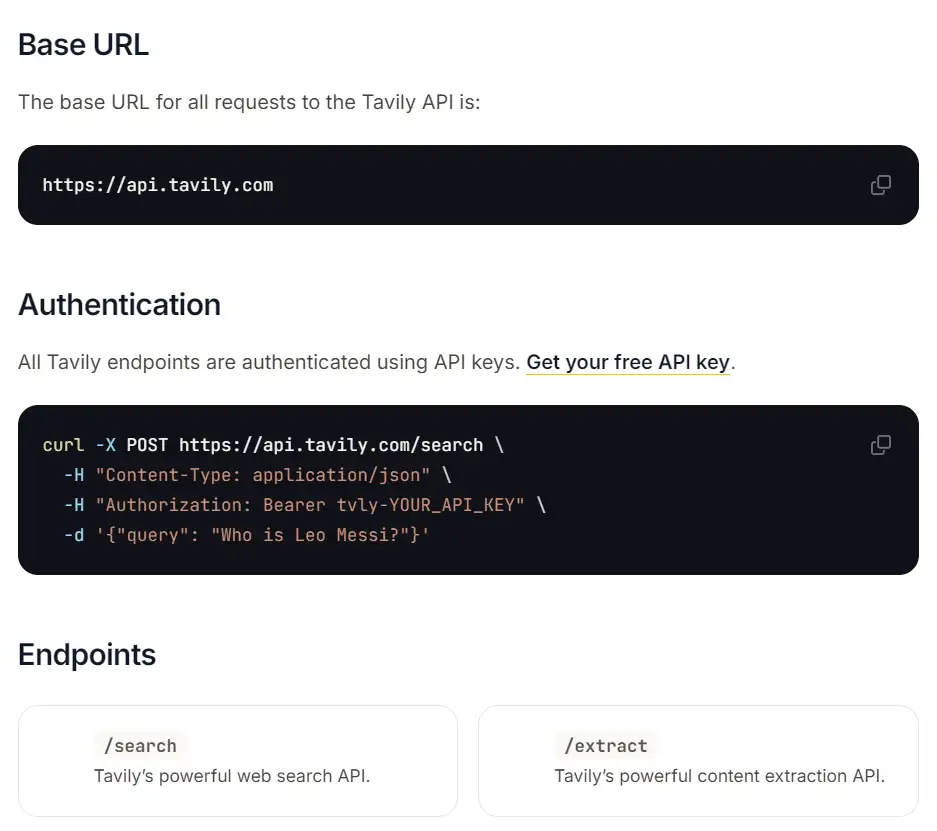

OpenAI 官方已经宣布支持 MCP 协议,尽管现阶段 MCP 还只是个玩具,但 VSCode 还是开始尝试提供接入 MCP 的原生功能。实在不知道接入什么玩的,可以试试 Tavily。打开命令面板,输入 MCP 后,可以看到『添加 MCP 服务器』和『列出 MCP 服务器』命令。

安装

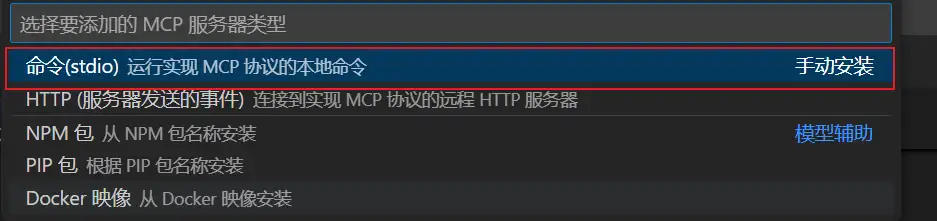

点击『添加 MCP 服务器』,使用第一项( stdio 模式),手动安装 MCP Server。使用 Tavily 需要使用 API Key,没有在线的第三方 Tavily MCP Server 提供 API Key,因此这类 MCP Server 的使用还是不要考虑 SSE/HTTP 模式,因为总是要使用你自己的 Tavily API Key。

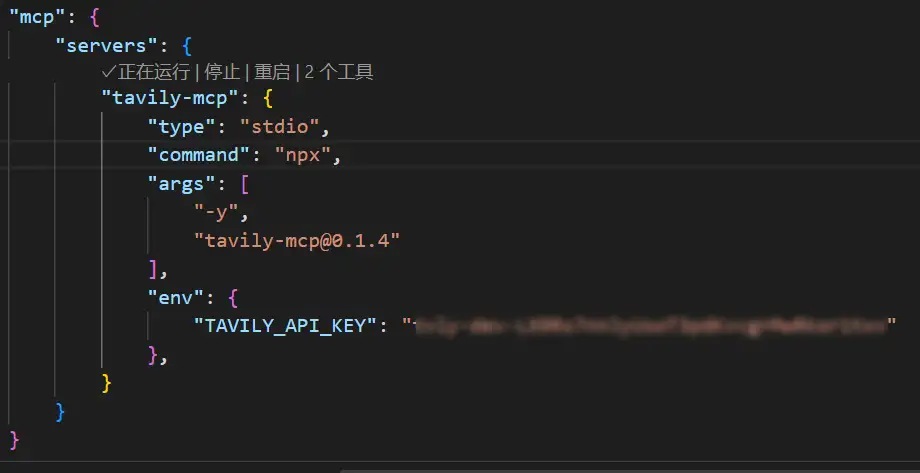

输入 npx 命令、指定名称后,最终,VSCode 为我们创建配置。然后,再手动补充以下内容,注意替换实际的 Tavily API Key。

"env": {

"TAVILY_API_KEY": "tvly-dev-xxxxxxx"

},

如果在其他应用程序(例如 Claude Desktop)中已经引入使用了 MCP 服务器,VS Code 可以自动发现运行。

接入与使用

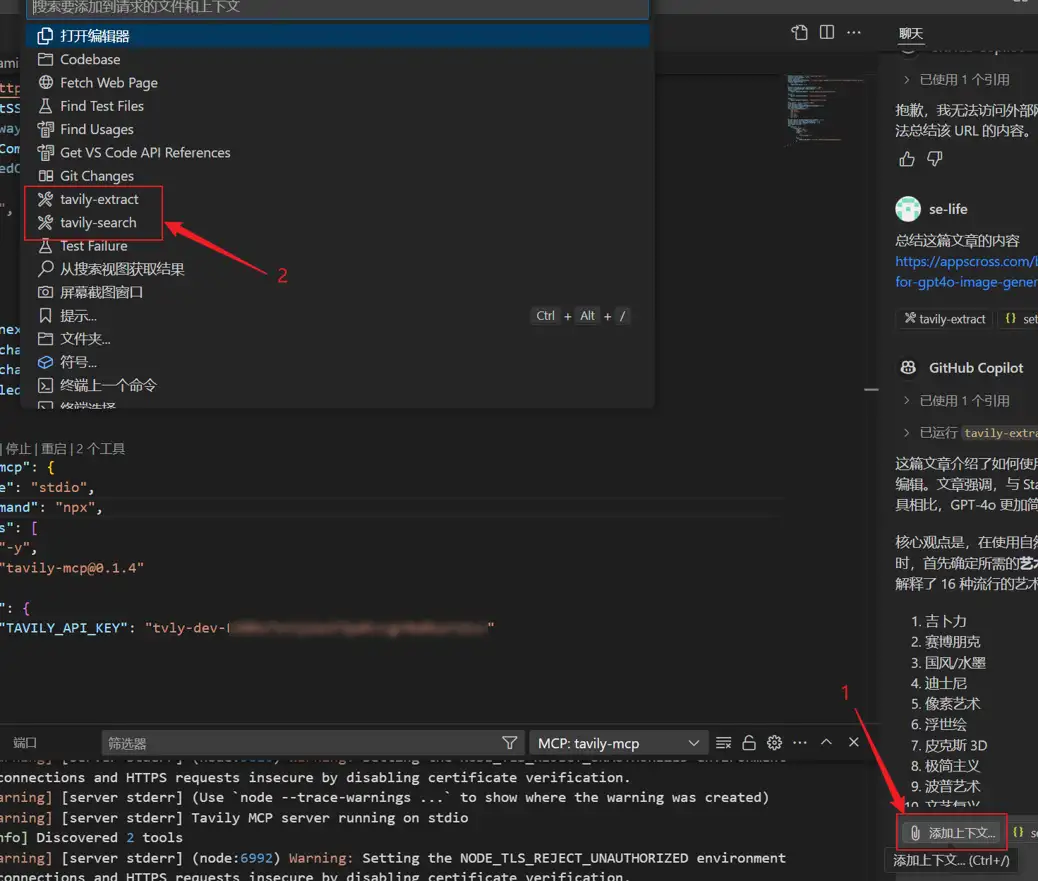

在 VSCode copilot 中,点击『添加上下文』,在弹出的上下文列表中,可选『tavily-extract』(总结)、『tavily-search』(搜索),这里选择总结,必须提供一个有效 URL,也就是总结文章的 URL,或者上传文章。目前 VSCode 中添加、使用 MCP 还不够方便,后续版本应该会逐步改进完善。

然后提交对话(Chat)就可以了,Tavily 调用的 LLM 取决于当前在 Copilot 中选择的模型。无论是否开发者,都可以直接调用 Tavily 官方的 API,每月 1000 次调用配额,和是否使用 MCP 接入无关,不清楚现阶段 MCP 有什么值得高潮的。

更多精彩,敬请关注「老E的博客」!

文章评论