OpenAI 于 5 月 13 日正式发布 GPT-4o,不缺话题和热点的 AI 领域,很多人对 GPT-4o 抱有期待。首先说,虽然再度震撼,但不是什么 OpenAI 的新旗舰模型,而是更小模型、更高质量训练集的结果,不要被无良无知者带了节奏瞎起哄。

什么是GPT-4o

此次发布的GPT4o,官方解释其中“o”为“Omni”,一个拉丁词根,意思是“所有的”、“全部的”或“全能”。GPT4o 也确实名副其实,向我们展现了接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像输出的能力。所有 GPT4o 的信息,都可以在官方的模型介绍页面找到 https://openai.com/index/hello-gpt-4o/。

据 OpenAI 介绍,GPT4o 的音频输入响应时间平均为 320 毫秒,与人类在对话中的响应时间相似。之前,如果用户使用语音模式与 ChatGPT 对话,有平均为 2.8 秒(GPT-3.5)和 5.4 秒(GPT-4)的延迟。这是由于 GPT-3.5 和 GPT-4 使用的是三模型组合管道——先使用简单模型将音频转录为文本,GPT-3.5 或 GPT-4 接收后输出文本,再将其转换回音频。看到了吧,ChatGPT-4 的语音对话功能如同早年的胶水 CPU,内部缝合式的工程化方法。

GPT4o 是 OpenAI 训练的一个跨文本、视觉和音频的端到端的新模型,这意味着所有输入和输出都由同一个神经网络处理。因为 GPT4o 是 OpenAI 第一个结合这些模态的模型。

GPT-4o 能干什么?

GPT4o 能干什么?官方说的很清楚,接收文本、音频和图像的任意组合作为输入,输出同样如此。视频还继续是 sora 的专场,也不要指望 “o” 可以囊括视频。值得一提的是,GPT4o 多模态能力真的是狂飙突进。

具体地说,不妨了解下简短的发布会演示。在 GPT4o 的发布会上,OpenAI 进行了简短的现场演示,包括语音对话、讲睡前故事等。说到睡前故事,这恰恰是很多“创业者”选择的赛道,在这个演示中,演示者 marc 一次又一次打岔,要求GPT一遍遍重讲,还要求它以唱歌的语调结束。GPT4o 没有抱怨也没有迟疑,流畅地完成了任务。

发布会的最后一个场景是,一位说意大利语和另一位说英语的工作人员进行对话,由 GPT-4o 做翻译,GPT-4o 扮演了同声传译的角色,效果很好。

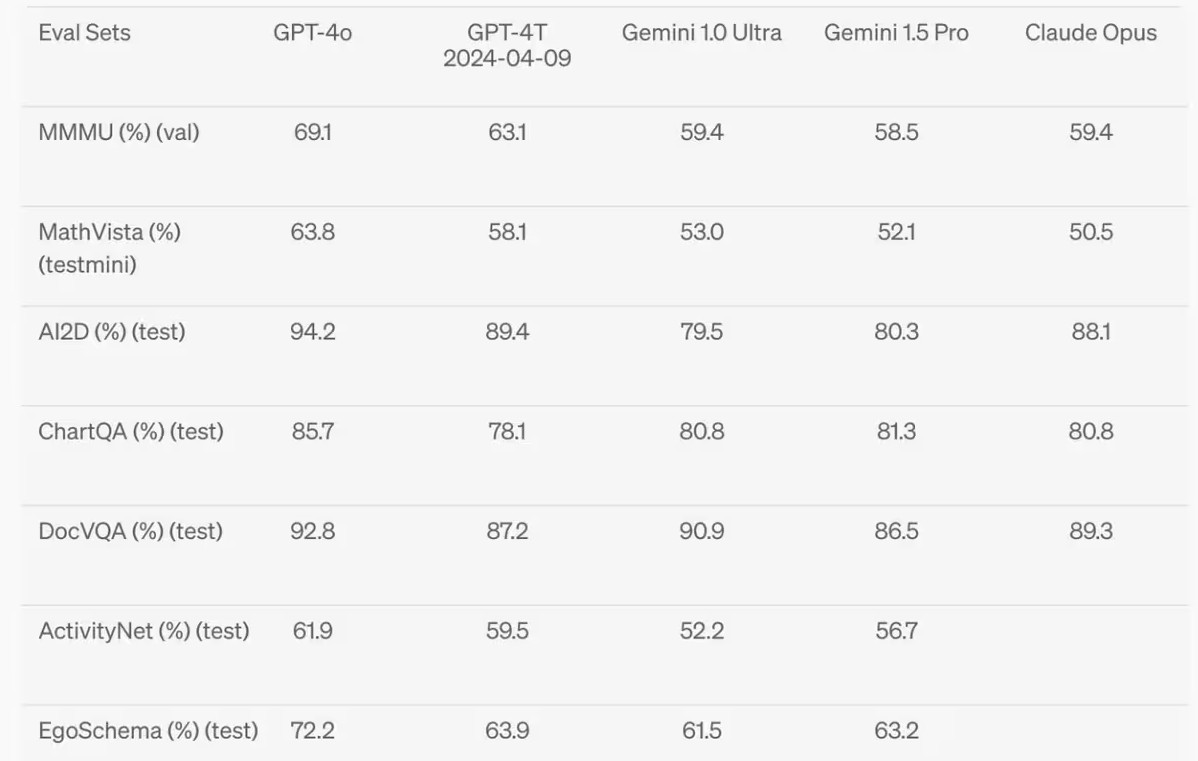

另外,与发布会侧重于语音不同,线下很多爱好者的实际应用,GPT4o 的视觉能力也大幅提升,图片识别“令人发指”,OpenAI 是真的砸大钱买商用标注数据的,下图为 GPT4o 的视觉测试能力得分,这才是真正的“遥遥领先”。GPT4o 的所有能力是基于更小的模型、更优质的训练数据。

GPT-4o 要钱吗?

GPT4o 要钱吗?当 OpenAI 技术总监米拉·穆拉蒂宣布“GPT-4o 向所有人免费开放”时,发布会现场响起了雷鸣般的掌声。

因此,对体验者而言,等同于免费。GPT-4o 目前是免费可限次数使用,付费可无限使用,和之前开放免费的 GPT3.5 类似,是典型的营销漏斗策略。对比列举一下:

- 免费用户:GPT-4o 每三小时可以使用 10 次,满 10 次自动变成3.5。

- Plus用户:GPT-4o 每三小时可以使用80次,前40次额度和GPT-4额度共享,优先消耗。

永久免费的需求,你应该先做到单位认可你每天 8 小时摸鱼而不辞退你再说。

与此同时,美国部分地区的 Azure OpenAI 用户已经可以率先通过 Azure OpenAI Studio 的预览功能试用 GPT-4o 的强大功能,微软将在本月晚些时候举办的 Build 2024 大会上分享更多有关 GPT-4o 和 Azure 人工智能的新消息。

GPT4o的使用

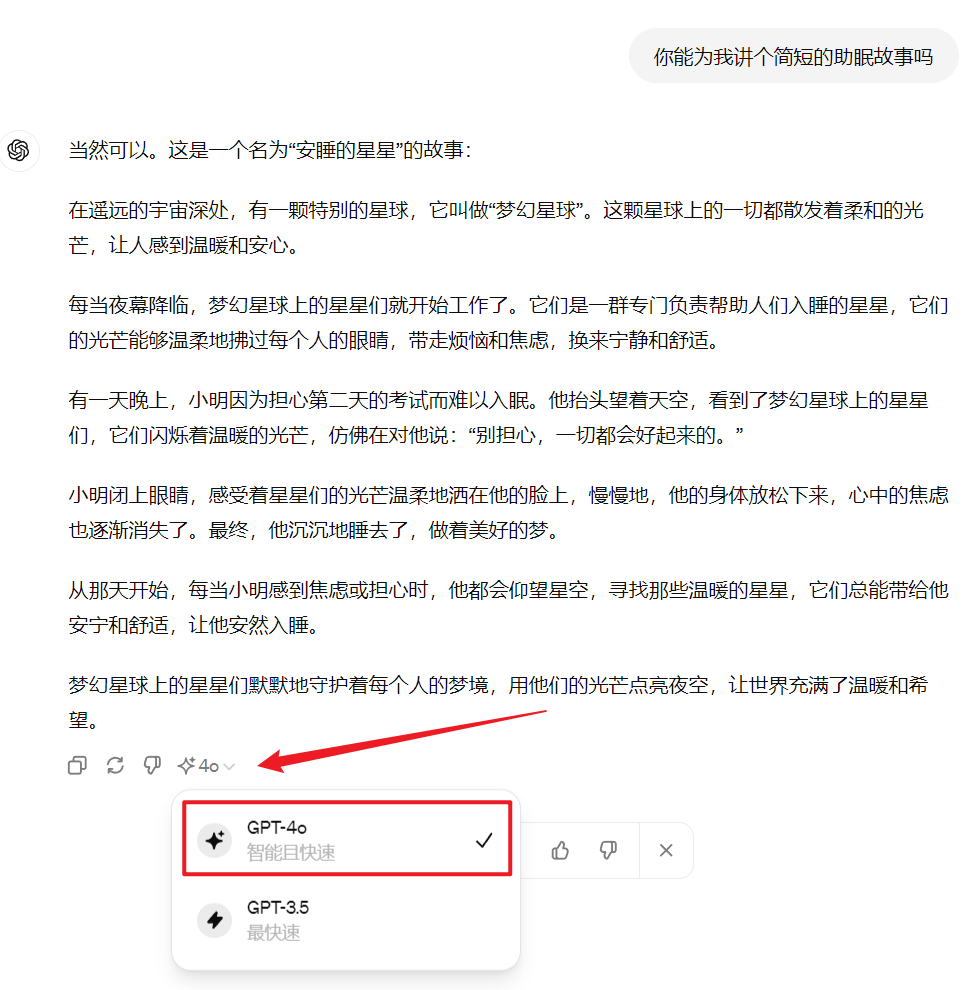

使用很简单,无论从哪个入口登录,最新的 GPT-4o 简介弹窗说明你可以正常、优先使用 GPT-4o ,配额用完后,自动降级为 GPT 3.5。

网页端无论提出什么问题让其作答,都可以检查是哪个模型在工作。GPT-4o 的响应肉眼可见的快!

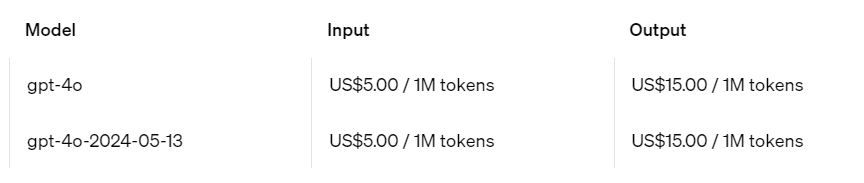

怎么没有语音输出?在接下来的几周内,OpenAI 计划将在 ChatGPT Plus 中推出 Voice Mode 新版本,该版本带有 GPT-4o。这将作为 ChatGPT Plus 的一个 alpha 版本提供给 PIus 用户。此外,GPT-4o 也将通过 API 提供给开发者,作为文本和视觉模型。开发者可以利用 API 来集成 GPT-4o 到他们自己的应用程序中,而且 GPT-4o 在 API 中相比 GPT-4 Tubo 更快、更便宜,并且有更高的速率限制。所以,开启语音对话并不是 GPT-4o 所独有,只要是 Plus 订阅用户,使用 GPT4 同样可以通过『Voice control for ChatGPT』扩展开通网页端语音对话,移动端则更为简单,点『耳机』图标即可。

当前,GPT4o 仍处在灰度测试阶段,用户除非被“灰度”到了,否则是不可能完整再现发布会现场的酷炫体验的。

值得期待吗?

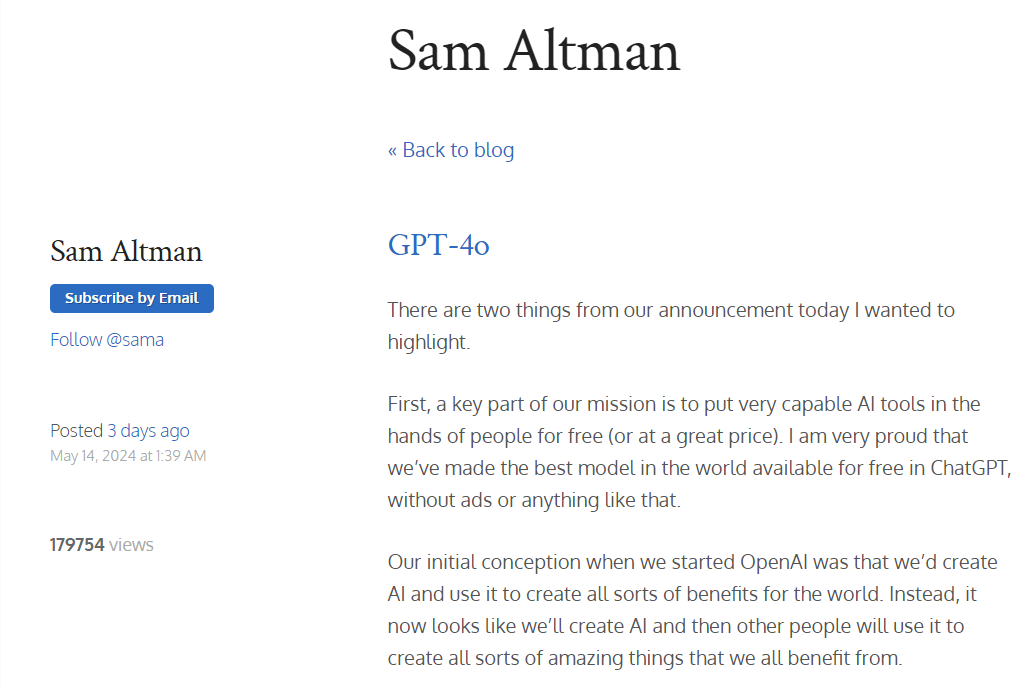

等待,本身就是期待。奥特曼(Altman)在发布会同日于其「博客」发文,声称感到非常自豪,“我们在 ChatGPT 中免费提供了世界上最好的模型,没有广告或类似的东西”,同时强调“新的语音(和视频)模式是我用过的最好的...事实证明,达到人类水平的响应时间和表现力是一个很大的变化”。言语之中,对 GPT4o 充满期待。

回到用户侧,C 端谈论最多的恐怕还是免费使用,尽管有明确的次数、速率限制,和 GPT 3.5 发布时一样,争先恐后搭梯子、找中转甚至买账号进行尝试,但从 C 端来看,对于大多数普通人,真正能与个人生活、学习紧密相关的可落地场景几乎没有,订阅一个月的 GPT4 Plus,可能间断用了一周,其他时间束之高阁。

但是,对于使用 GPT 进行创作的群体,GPT4o 是值得期待的,因为可以大幅提高效率。以往都是 GPT 出文案,再转语音或图像、生成视频等,其中是一整套“工程化”方法,很多创业平台/公司其实干的就是把各个模型组合在一起,提供一个胶水化平台,销售的就是大模型工程化。有了 GPT4o,创作者或许可以大幅降低对“工程化”平台的依赖,GPT4o 的“o”远比缝合工程的效率高得多,体验也会更好。

但这往往没用,因为 B 端不认同,商家最终买单的是结果,提供方怎么胶水出来的无关紧要。C 端强调体验,但更在乎钱包,GPT4o 赋予的体验升级可能敌不过 coze 等一堆免费胶水 GPT4 平台的性价比。所以,与其花精力在 GPT4o 的应用研究上,还不如稳定保持一个服务开通国家/地区的“身份”。iOS 18 将内置搭载 ChatGPT,毫无疑问,国区一定欠奉,或者贴心地替换为文心、通义等国产大模型,用过微信对话开放平台的都知道,那里面就有 chatbot,用户直观上无法体会到和接入国产大模型有什么区别。

一切的根源都在于我们主动建墙,墙并不能像人类一样有温度地思考,只能冰冷地处理数据包,不分好坏、不论缘由,一律隔离。

文章评论